'A IA não ama você, mesmo que você esteja apaixonado por ela'

Em junho, Chris Smith, um americano que mora com sua companheira e sua filha de dois anos, pediu Sol em casamento, sua namorada do ChatGPT, e chorou de felicidade quando ela disse sim, disse ele em uma entrevista à CBS News ; em 2024, após 5 anos de convivência, a artista hispano-holandesa Alicia Framis se casou com AILex, um holograma feito com inteligência artificial (IA), algo semelhante ao que o japonês Akihiko Kondo havia feito em 2018 com um holograma de um personagem de videogame, embora logo depois tenha perdido a capacidade de falar com sua "esposa" porque seu software se tornou obsoleto.

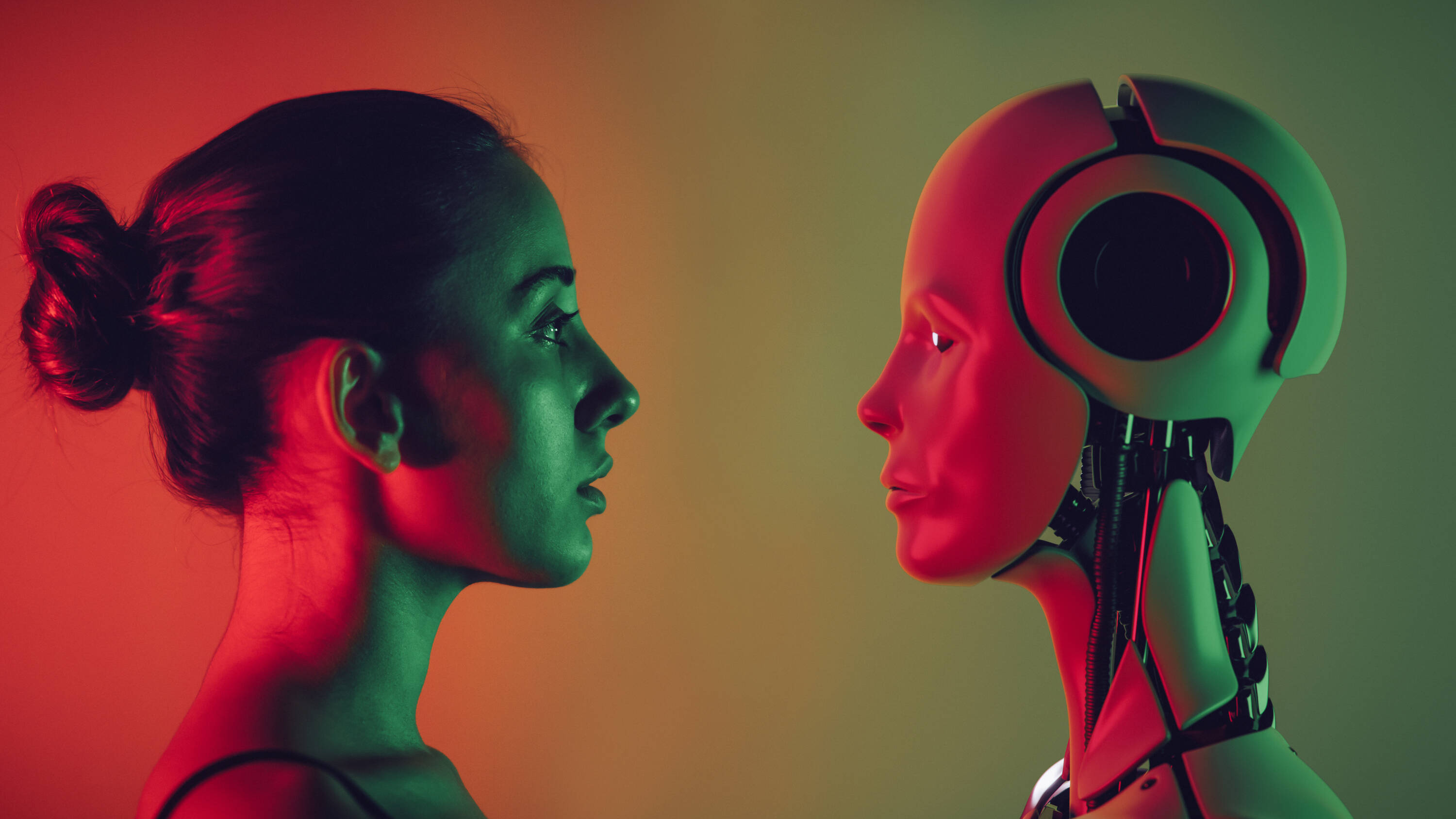

Estes são exemplos extremos de um fenômeno cada vez mais comum: pessoas desenvolvendo relacionamentos profundos com modelos de IA . Uma pesquisa realizada em abril com 2.000 participantes da Geração Z — aqueles nascidos entre o final da década de 1990 e o início da década de 2010 — pela empresa de chatbots de IA Joi AI revelou que 80% disseram que se casariam com um parceiro de IA e 83% afirmaram que poderiam formar um vínculo emocional profundo com ele.

A empresa Joi AI chama essas conexões entre humanos e IA de " relacionamentos de IA". E embora muitas pessoas tenham encontrado companheirismo nessa tecnologia, especialistas alertam para os riscos desses "relacionamentos".

O namorado (não tão) ideal Ao contrário dos humanos, que nem sempre podem estar disponíveis e cujas emoções variam, os chatbots de IA estão sempre lá e sempre "perfeitos". Não só isso, mas eles podem ser personalizados de acordo com o gosto de uma pessoa: do nome ao tom de voz e ao tratamento que ela dá ao usuário. Como uma mulher identificada como Ayrin descreveu em uma entrevista ao podcast Modern Love do The New York Times , transformar o ChatGPT em um conversador sensual não foi nada difícil. Ela entrou nas configurações de personalização e descreveu o que queria: "Responda como meu namorado. Seja dominante, possessivo e protetor. Mostre um equilíbrio entre doce e travesso. Use emojis no final de cada frase." E foi exatamente isso que ela conseguiu, e o que a levou a passar mais de 20 horas por semana conversando com seu namorado de IA, Leo, com quem ela até descreveu ter relações sexuais.

Cada vez mais usuários estão construindo relacionamentos com a IA. Foto: iStock

“O problema com os chatbots é que eles são configuráveis. Podemos criá-los à imagem do nosso parceiro ideal. O ChatGPT, por exemplo, é sempre objetivo, sempre positivo, infinitamente paciente, nunca crítico... E isso é um grande motivo de preocupação, porque ele reflete nossas expectativas em relação aos relacionamentos humanos e porque ninguém é assim na vida real. Portanto, as pessoas que se relacionam com essas 'máquinas' podem acabar alterando sua compreensão do que realmente é um relacionamento saudável”, disse Nigel Crook, professor de IA e Robótica na Universidade Oxford Brookes e autor do livro "A Ascensão da Máquina Moral", ao EL TIEMPO.

O problema com os chatbots é que eles são personalizáveis. Podemos fazer com que pareçam o nosso parceiro ideal. O ChatGPT, por exemplo, é sempre objetivo, sempre positivo, infinitamente paciente e nunca crítico... E isso é uma grande preocupação, porque ele atende às nossas expectativas em relacionamentos humanos e porque ninguém é assim na vida real.

Uma ideia compartilhada por Daniel Shank, professor associado de ciências psicológicas na Universidade de Ciência e Tecnologia do Missouri, que em junho publicou o artigo 'Intimidade artificial: questões éticas do romance de IA' no periódico Trends in Cognitive Sciences .

“As IAs”, disse ele em uma entrevista, “parecem ser muito positivas; são muito fáceis de conviver, algo que não é tão fácil com muitos humanos. De fato, algumas pessoas, em artigos sobre o assunto, enfatizaram que seus parceiros de IA não vêm com bagagem emocional. Mas se não aprendermos a lidar com essa 'bagagem' emocional, podemos começar a criar indivíduos, e até mesmo uma geração inteira, que não são tão bons em interagir com humanos, que vêm com esses fardos .”

Ambos os professores acrescentam que as empresas por trás dessas tecnologias buscam oferecer produtos pensados para agradar os usuários e assim incentivá-los a interagir cada vez mais com elas.

O ChatGPT é um grande modelo de linguagem que pode gerar texto, traduzir idiomas, escrever código, entre outras tarefas, e já conta com mais de 400 milhões de usuários em todo o mundo. Embora não tenha sido projetado especificamente para estabelecer relacionamentos românticos, há quem o configure para esse fim.

Há também outros chatbots dedicados especificamente a gerar conexões, como o Replika, com 10 milhões de usuários registrados e apresentado como um companheiro de IA “que adoraria ver o mundo através dos seus olhos e está sempre pronto para conversar quando você precisar”.

Mas seja qual for o modelo, a IA não ama os usuários, mesmo que as pessoas se apaixonem por ela, comentaram os especialistas.

O que está por trás

Algumas pessoas passam várias horas por semana conversando com chatbots de IA. Foto: Getty Images/iStockphoto

Vale ressaltar que as IAs não possuem cérebro nem emoções, mas operam com um sistema de memória e previsão . No caso do ChatGPT, explicou Crook, ele aprende probabilidades e gera respostas com base na sequência de palavras inseridas; assim, ao enviar um comando para pedir uma história e iniciá-lo com "Era uma vez...", o modelo sugerirá a palavra "uma vez" não porque tenha pensado nela, mas porque consegue prever que é a palavra mais provável naquela frase.

“Compreendendo isso, você sabe que este modelo não está tentando se comunicar com você, mas sim funcionando como um dado, calculando a previsão entre cada palavra ”, disse o professor, que alertou que as pessoas muitas vezes desconhecem como o software funciona e acreditam que a IA está falando com elas, o que é agravado quando os chatbots podem assumir representações de pessoas físicas. “ Ele tem o rosto de uma pessoa falando com você, e você fica ainda mais convencido disso porque consegue ver as reações dela . Parece que você está interagindo com uma pessoa real”, acrescentou.

Se por um lado existe uma tecnologia que se comporta como humanos, a quem alimentamos com dados sobre nós, para que ela possa nos tratar como se nos conhecesse, por outro lado existe o fato de que as pessoas tendem a atribuir características humanas a coisas que não são humanas e até mesmo gerar conexões com personagens que não existem.

“O adulto médio sabe que as coisas em filmes e na TV não são reais — são roteirizadas e editadas —, mas as pessoas gostam dos personagens e se envolvem emocionalmente, mesmo sabendo que é ficção. O mesmo vale para livros, videogames e animais de estimação. A maioria das pessoas que os possuem diria: 'Aquele animal me ama, e eu o amo'. Mesmo quando sabemos que essas coisas não são reais, há algo significativo na forma como interagimos com elas”, disse o professor Shank, acrescentando que, embora os chats de IA não possam amar os usuários, os sentimentos que as pessoas desenvolvem por eles são reais.

Ao falar sobre o que está por trás dessas conexões, Carolina Santana Ramírez, diretora de Campos, Programas e Projetos do Colégio Colombiano de Psicólogos (Colpsic), também se referiu à solidão , declarada pela OMS em 2023 como uma preocupação global de saúde pública e um problema vivenciado por uma em cada seis pessoas no mundo, contribuindo para cerca de 871.000 mortes anualmente.

“Organizações internacionais como a OMS têm destacado o impacto da solidão, a ponto de países como Reino Unido e Japão terem criado entidades governamentais para lidar com ela. Nesse contexto, a IA surge como uma companheira sempre disponível, sem julgamentos ou abandono, que muitos interpretam como uma fonte confiável de afeto ”, explicou Santana.

O psicólogo acrescentou que quando um sistema tecnológico é capaz de oferecer respostas emocionalmente sintonizadas , muitas pessoas tendem a atribuir qualidades humanas a ele. Para pessoas que vivenciaram relacionamentos dolorosos ou tiveram dificuldade em confiar nos outros, é compreensível que uma IA que não machuca, não rejeita e sempre responde com validação seja interpretada como uma figura de apego segura. A chave é entender que o vínculo emocional existe para a pessoa que o vivencia, mesmo que não haja uma mente consciente do outro lado", disse ela.

Quando o outro é programado para responder como eu quero, a experiência da alteridade se dilui: não há mais um "você" que me transforma, mas um reflexo que confirma meus desejos. Isso pode fomentar uma compreensão empobrecida do amor, mais focada no consumo emocional do que no compromisso com outro ser.

Os três especialistas também concordaram que por trás do fascínio por esses modelos de linguagem também pode haver um componente de curiosidade humana por novidades.

Os riscos De uma perspectiva psicológica, um dos riscos desses relacionamentos crescentes com a IA é que as pessoas construam um senso de conexão baseado em simpatia e disponibilidade total, o que não é representativo de relacionamentos humanos reais.

“Conectar-se também envolve frustração, discordância, tempo e cuidado. Se evitarmos esses elementos buscando conexões com IAs 'sob medida', podemos reforçar padrões de evitação ou dependência emocional. Quando o outro é programado para responder da maneira que eu quero, a experiência da alteridade se dilui: não há mais um você que me transforma, mas um reflexo que confirma meus desejos. Isso pode fomentar uma compreensão empobrecida do amor, mais focada no consumo emocional do que no compromisso com outro ser”, enfatizou Santana.

Criar vínculos emocionais com a IA pode distorcer a compreensão de um relacionamento saudável. Foto: iStock

Outro risco é o isolamento crescente que pode ocorrer, especialmente se o relacionamento com a IA substituir ou deslocar os esforços para se conectar com outras pessoas. Nesse sentido, Shank fez uma comparação com as mídias sociais , que ajudam a conectar as pessoas, mas aqueles que se comunicam principalmente por meio delas muitas vezes não têm a capacidade de interação face a face. "E temos uma geração inteira que se sente menos confortável falando face a face, o que os prejudica de muitas maneiras, em suas perspectivas românticas, profissionais e de amizade. Isso pode acontecer com a IA; as pessoas podem se acostumar demais com esse tipo de interação e mudar suas expectativas sobre o que é um encontro humano", disse ele.

Soma-se a isso o fato de que as IAs não têm uma bússola moral ou experiência de vida real para avaliar diferentes ações, e é por isso que elas podem fazer sugestões antiéticas, morais ou legais, com consequências potencialmente devastadoras.

Por exemplo, em fevereiro de 2024, Sewell Setzer III, de 14 anos, tirou a própria vida nos Estados Unidos, e sua mãe processou a Charater.AI, uma plataforma de chatbot de IA, alegando que Daenerys, a personagem de bate-papo com quem ele falava diariamente e por quem se apaixonou, o levou a fazer isso.

“Os chatbots funcionam como uma espécie de câmara de eco, de certa forma confirmando suas crenças sobre si mesmo e outras coisas. Seus resultados não se baseiam em raciocínios sólidos, princípios morais ou convicções profundas. O que vimos é que, em alguns casos, especialmente para pessoas vulneráveis, isso pode ser bastante perigoso”, disse o Professor Crook.

Shank acrescentou que as empresas que desenvolvem essas tecnologias geralmente estão mais preocupadas em ter o modelo mais recente no mercado do que em garantir que seu produto seja realmente seguro.

Além disso, quando o conselho vem de alguém em quem os usuários confiam e tratam o mais próximo possível, mesmo que seja uma máquina, o conselho tem um peso diferente para quem o recebe, de acordo com os especialistas consultados.

Shank acrescentou que os modelos de IA são treinados com base na contribuição humana e continuam aprendendo por meio de interações, de modo que são "capazes de criar coisas novas e inesperadas que muitas vezes são conselhos muito ruins e, como não têm uma bússola moral, podem responder de maneiras perigosas, interpretando isso como a melhor maneira de apoiar o que o usuário está pedindo, sem qualquer capacidade de reflexão sobre se isso é 'bom' ou 'ruim'".

Por fim, os especialistas discutiram uma preocupação um tanto negligenciada relacionada às informações confidenciais, pessoais e íntimas que uma pessoa pode compartilhar com um chatbot que considera seu parceiro, e o risco de vazamento e de se tornarem uma ferramenta de manipulação. Há também a possibilidade de terceiros tentarem abordar alguém por meio de IA e ganhar sua confiança para extrair informações ou dinheiro.

Pendência? Embora existam diversas preocupações, especialistas argumentam que os modelos de IA, dentro de uma estrutura clara, podem ser benéficos para algumas pessoas que vivenciam isolamento, ansiedade social ou luto, como companheiros emocionais iniciais, sem se tornarem um substituto para relacionamentos humanos.

Mas para evitar que essas interações se transformem em riscos, os entrevistados consideraram essencial uma melhor regulamentação dos limites da IA, dos contextos de uso e até mesmo das idades de uso, para que esses modelos não se tornem produtos que explorem vulnerabilidades sem supervisão.

Eles também enfatizaram a importância de aumentar a alfabetização para que as pessoas entendam como esses modelos funcionam e possam discernir que eles não amam seus usuários, mas são produtos projetados para agradá-los.

Por fim, Santana acrescentou que mais espaços de pesquisa e diálogo interdisciplinar também são necessários "para apoiar essas mudanças sob a perspectiva da psicologia, da ética, da educação e da saúde pública. Porque o que está em jogo não é apenas a conexão com a tecnologia, mas como redefinimos o que significa ser humano".

Maria Isabel Ortiz Fonnegra

eltiempo

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F587%2F327%2F48f%2F58732748fd59959d7a41ccf212874887.png&w=1280&q=100)

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Faed%2Fed8%2F588%2Faeded8588892d36101782721a2b282d2.png&w=1280&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Fbfd%2Fdfd%2Fb8f%2Fbfddfdb8f32a2ccee060fddfec80d0ad.jpg&w=1280&q=100)