Como é esse GPT 5: aqui estão as opiniões iniciais de especialistas internacionais

O novo modelo GPT 5 representa o horizonte de maturidade da inteligência artificial. Uma evolução qualitativa, em vez de quantitativa, que consolida o progresso alcançado até o momento e a torna mais utilizável. Mais eficaz, em todos os aspectos. Assim, o GPT 5 desloca ainda mais o foco da IA generativa. Este parece ser o primeiro consenso entre a imprensa especializada internacional sobre a chegada do GPT 5, que — vale lembrar — já está disponível na Itália, inclusive gratuitamente no ChatGPT.

Quem sabe se isso realmente representa — como afirma Sam Altman, chefe da OpenAI — um avanço em direção à inteligência artificial geral. Mais provavelmente, os especialistas a veem como uma transição para a "inteligência operacional". A imprensa especializada está impressionada com as inúmeras melhorias práticas e mensuráveis. O GPT 5 demonstra um raciocínio mais robusto em cadeias de tarefas, a capacidade de executar operações que antes exigiam mais orquestração humana e um desempenho de codificação de última geração, conforme observado pela publicação americana Tom's Guide.

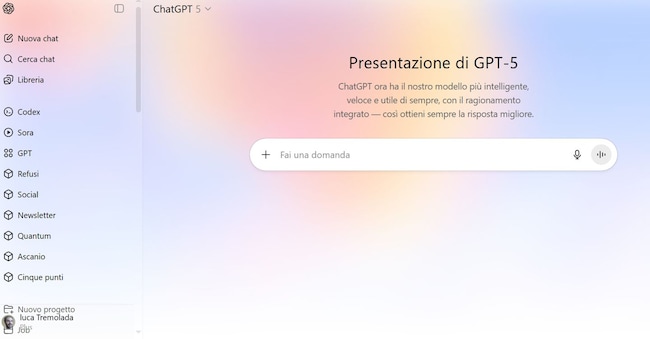

Interface

Muitos estão impressionados com a limpeza da interface do Chatgpt, que não solicita mais o modelo e escolhe automaticamente se deve raciocinar. Esse progresso demonstra um aumento na capacidade de tomada de decisão autônoma, bem como na eficiência energética e computacional, observa a MIT Technology Review. Essa eficiência também é demonstrada pela decisão de tornar o Gpt 5 gratuito para todos no Chatgpt. É claro que os usuários ainda podem forçar o recurso "pensar mais" e outras ferramentas com um clique; e se o Chatgpt começar a raciocinar, eles podem forçar uma resposta imediata.

As avaliações iniciais da qualidade do raciocínio aplicado a problemas do mundo real são positivas. De acordo com testadores e comentaristas técnicos (Tom's Hardware, Techtarget), o GPT 5 demonstra maior consistência na resolução de problemas com múltiplas etapas e uma maior propensão a completar sequências de operações sem perder o fio da meada. Esse progresso impacta a forma como é utilizado. Agora, o modelo não se limita a responder, mas governa fluxos de trabalho que integram busca, manipulação de dados e saída final. Os relatórios dos primeiros testadores em sites de referência parecem confirmar que o progresso não é aleatório e improvisado; na verdade, é o resultado de intervenções de ajuste do OpenAI voltadas especificamente para esses cenários práticos. Lembre-se de que o OpenAI levou dois anos para ser desenvolvido dos modelos 4 para 5.

Falando em progresso prático, a empresa também afirma que as alucinações diminuíram em 26% e que agora há uma chance 44% menor de que uma resposta contenha um erro factual significativo. Por enquanto, a empresa é a única a falar sobre o assunto, mas especialistas já afirmam que, mesmo que fosse esse o caso, ainda não seria o ideal: significa que uma em cada dez respostas ainda pode conter alucinações, observa o Mashable, e isso é extremamente grave, considerando um uso cada vez mais comum: pedir opiniões médicas ao Chatgpt.

A OpenAI testou o GPT-5 em seu benchmark interno, o Simple QA. Este teste é uma coleção de "perguntas de descoberta de fatos com respostas curtas que medem a precisão do modelo para tentativas de resposta", de acordo com a descrição do sistema. Para esta avaliação, o GPT-5 não tinha acesso à internet e, portanto, as alucinações foram muito altas: 47% (40% com raciocínio), contra 52% para o GPT-5.

Beth Barnes, fundadora da organização sem fins lucrativos de pesquisa em inteligência artificial Metr, rapidamente identificou uma imprecisão em uma resposta do GPT-5 explicando como os aviões funcionam.

Muitos citam o progresso da codificação como uma das conquistas mais significativas do GPT 5, diminuindo a diferença em relação ao Claude Sonnet da Anthropic (agora a ferramenta de IA mais utilizada para programação). Dados compartilhados pela OpenAI e ecoados por publicações de tecnologia mostram que o modelo alcança pontuações mais altas em benchmarks orientados a software (SWE-Bench e similares); ele usa menos tokens e menos chamadas para ferramentas externas para resolver o mesmo problema. A diferença aqui é dupla: o modelo não só é mais preciso na produção de código útil, como também o faz de forma mais eficiente, o que reduz os custos de uso em escala e aumenta sua atratividade para produtos comerciais que visam automatizar parte do ciclo de desenvolvimento. Testes extensivos certamente serão necessários para entender sua verdadeira qualidade em comparação com os concorrentes, tanto na prática quanto em termos de integração com sistemas de terceiros.

Menos centrais para o debate, mas não menos importantes, são duas outras questões: a janela contextual e a multimodalidade. Análises técnicas relatam que o GPT 5 foi projetado para lidar com contextos muito maiores — os números variam dependendo da fonte e da configuração, mas a direção é clara: trabalhar com documentos longos, projetos com várias partes ou conversas com memória estendida torna-se viável sem a necessidade de recapitular informações constantemente. Essa capacidade tem sido interpretada por muitos especialistas (Tom's Hardware, PanelsAI) como um facilitador para aplicações profissionais: revisões de contratos, relatórios contínuos e análises financeiras que exigem consistência em centenas de páginas agora podem ser gerenciadas com menos intervenção humana. Ao mesmo tempo, fontes técnicas enfatizam que o termo "multimodal" deve ser entendido pragmaticamente: uma melhor integração de texto, imagens e dados estruturados já está presente; áudio e vídeo são potencialmente trabalhos em andamento, mas a robustez prática depende de casos de uso e pipelines de integração.

Outro tema recorrente nas páginas especializadas diz respeito às capacidades agênticas e às ferramentas projetadas para desenvolvê-las. A imprensa técnica (Techcrunch, Digital Watch Observatory) dedicou uma cobertura aprofundada aos novos recursos de infraestrutura que acompanham o modelo: API de Respostas, SDK de Agentes e sistemas de roteamento que permitem ao modelo decidir se deve usar um modo "pensante" ou uma resposta rápida são elementos que transformam o GPT 5 em uma plataforma para agentes personalizados, em vez de um simples endpoint para preenchimento automático de texto. Especialistas explicam que, graças a essas APIs e SDKs, desenvolvedores e empresas podem orquestrar pilhas — pesquisas na web, chamadas internas a bancos de dados, geração de artefatos (slides, planilhas, código) — com controles de segurança e backups. Isso reduz a lacuna entre o protótipo e o produto de produção.

Ao lado do tom positivo, no entanto, a imprensa técnica mantém um tom crítico e comedido: blogs e analistas de renome pedem verificação independente e benchmarks reproduzíveis antes de tratar o lançamento como um "avanço" definitivo. A Platformer, a Hacker News e outros comentaristas do setor apontam que as métricas apresentadas em briefings ou comunicados à imprensa podem ser influenciadas por conjuntos de testes pré-selecionados e condições de ajuste que não são replicadas automaticamente em todos os ambientes de produção. A comunidade aberta e os fóruns técnicos — onde surgem testes improvisados e comparações de base — também observam que a percepção de utilidade pode variar radicalmente dependendo do domínio: o que funciona bem para escrever código não é automaticamente transferível para tarefas de avaliação clínica ou processos regulamentados. Essa demanda por mensuração independente é um refrão recorrente na imprensa técnica.

Custo e acesso são outra questão crítica. Diversos artigos (como o Platformer e o The Verge) destacam como a OpenAI optou por uma estratégia multicamadas: modelos "mini" e "nano" para casos de baixo custo e baixa latência, uma versão "padrão" para tarefas pesadas e integração direta com o Chatgpt. Publicações do setor observaram que essa mudança ampliará a base de uso. Ao mesmo tempo, especialistas apontam que o verdadeiro parâmetro econômico a ser monitorado continua sendo o preço por token nos pipelines de produção: a eficiência do Gpt 5 em gerar respostas com menos tokens e menos chamadas de ferramentas pode se traduzir em uma vantagem competitiva, mas o cálculo de custos depende estritamente do tipo de carga de trabalho e dos padrões de uso. Portanto, recomenda-se cautela.

Mas, especialmente em relação à segurança e governança, a imprensa especializada é cautelosa: a capacidade ampliada do modelo de gerar artefatos complexos e orquestrar ações em recursos externos exige novas ferramentas de auditoria, limites de acesso e políticas operacionais. Especialistas técnicos enfatizam que o desafio não é apenas reduzir alucinações, mas gerenciar dependências entre o modelo e os sistemas corporativos — como uma resposta é verificada, quem é responsável pela saída e como a cadeia de decisões é rastreada na presença de agentes autônomos. Discussões técnicas enfatizam questões práticas: registro em log, testes em ambientes isolados, aprovações humanas obrigatórias para saídas sensíveis e critérios claros para bloquear recursos de risco.

Tudo isso soa muito familiar para nós, europeus, já que em 2 de agosto entraram em vigor as obrigações da Lei de IA para provedores de modelos de uso geral (como o Gpt 5), com implicações também para as empresas que os utilizam.

Notícias e insights sobre eventos políticos, econômicos e financeiros.

Inscrever-seilsole24ore