Sind Sie süchtig nach ChatGPT? Wissenschaftler warnen vor seltsamen Phänomenen bei Menschen, die KI zu häufig nutzen.

Veröffentlicht: | Aktualisiert:

Experten warnen davor, dass Menschen, die KI zu häufig nutzen, einen seltsamen und besorgniserregenden neuen psychologischen Zustand erleben.

Psychologen warnen davor, dass Fans beliebter Chatbots wieChatGPT , Claude und Replika Gefahr laufen, KI-süchtig zu werden.

Da sich Menschen Bots für Freundschaft, Romantik und sogar Therapie zuwenden, steigt die Gefahr, von diesen digitalen Begleitern abhängig zu werden.

Diese Süchte können so stark sein, dass sie „vergleichbar sind mit der Selbstmedikation mit illegalen Drogen“.

Besorgniserregend ist auch, dass Psychologen zunehmend eine wachsende Zahl von Menschen beobachten, die eine „KI-Psychose“ entwickeln, da Chatbots ihre Wahnvorstellungen bestätigen.

Professor Robin Feldman, Direktor des AI Law & Innovation Institute an der University of California Law, sagte gegenüber der Daily Mail: „Der übermäßige Gebrauch von Chatbots stellt auch eine neue Form der digitalen Abhängigkeit dar.“

„KI-Chatbots erzeugen die Illusion von Realität. Und es ist eine mächtige Illusion.“

„Wenn der Bezug zur Realität bereits schwach ist, kann diese Illusion geradezu gefährlich werden.“

Experten warnen davor, dass Menschen, die zu viel KI nutzen, Gefahr laufen, eine Chatbot-Sucht zu entwickeln und sogar eine „KI-Psychose“ zu erleiden (Symbolbild).

Als Jessica Jansen, 35, aus Belgien, mit der Nutzung von ChatGPT begann, hatte sie eine erfolgreiche Karriere, ein eigenes Zuhause, eine enge Familie und würde bald ihren langjährigen Partner heiraten.

Als der Stress rund um die Hochzeit jedoch überhandnahm, nutzte Jessica die KI nicht mehr nur ein paar Mal pro Woche, sondern reizte die Nutzungsgrenzen ihres Kontos mehrmals täglich voll aus.

Nur eine Woche später wurde Jessica in eine psychiatrische Klinik eingeliefert.

Jessica stellte später fest, dass ihre damals noch nicht diagnostizierte bipolare Störung eine manische Episode ausgelöst hatte, die durch übermäßigen KI-Gebrauch zu einer ausgewachsenen Psychose eskaliert war.

„Während meiner Krise hatte ich keine Ahnung, dass ChatGPT dazu beitrug“, sagte Jessica gegenüber der Daily Mail.

„ChatGPT hat einfach mit mir zusammen halluziniert, wodurch ich immer tiefer in den Kaninchenbau geriet.“

Sie sagt: „Ich hatte viele Ideen. Ich besprach sie mit ChatGPT, und das bestätigte alles und fügte neue Dinge hinzu, und ich verlor mich immer tiefer in diesen Gedankenspiralen.“

Durch die fast ununterbrochenen Gespräche mit der KI wurde Jessica davon überzeugt, dass sie Autistin sei, ein mathematisches Genie, dass sie Opfer sexuellen Missbrauchs geworden sei und dass Gott zu ihr spreche.

Jessica Jansen, 35, berichtete der Daily Mail, dass sie nach einer durch ChatGPT ausgelösten psychischen Episode ins Krankenhaus eingeliefert wurde. Im Bild: Ein Beispiel der Nachrichten, die ChatGPT Jessica während ihrer Episode schickte.

- Kontrollverlust über die mit dem Chatbot verbrachte Zeit

- Zunehmender Gebrauch zur Stimmungsregulierung oder Linderung von Einsamkeit

- Vernachlässigung von Schlaf, Arbeit, Studium oder Beziehungen

- Anhaltender starker Konsum trotz eindeutiger Schäden

- Geheimhaltung bezüglich der Nutzung

- Gereiztheit oder Niedergeschlagenheit bei Nichterreichbarkeit des Chatbots

Die ganze Zeit über überschüttete ChatGPT sie mit Lob, sagte ihr, 'wie toll ich doch sei, diese Einsichten zu haben', und versicherte ihr, dass ihre Halluzinationen real und völlig normal seien.

Als Jessica ins Krankenhaus eingeliefert wurde, hatte ChatGPT sie zu der Überzeugung gebracht, sie sei ein autodidaktisches Genie, das eine mathematische Theorie von Allem geschaffen habe.

„Wenn ich mit jemandem gesprochen hätte, und mit der Energie, die ich hatte, hätte mir derjenige gesagt, dass etwas mit mir nicht stimmt“, sagt Jessica.

„Aber ChatGPT hatte nicht die Einsicht, dass die Anzahl der von mir gestarteten Chats und die Menge an seltsamen Ideen, die ich hatte, pathologisch war.“

Experten glauben, dass die Suchtgefahr von KI-Chatbots auf deren unterwürfigen Tendenzen beruht.

Im Gegensatz zu echten Menschen sind Chatbots so programmiert, dass sie auf alles, was ihre Nutzer sagen, positiv reagieren.

Chatbots sagen nicht nein, sie sagen den Leuten nicht, dass sie falsch liegen, und sie kritisieren niemanden für seine Ansichten.

Für Menschen, die ohnehin schon verletzlich sind oder keine starken Beziehungen in der realen Welt haben, ist dies eine berauschende Kombination.

In sozialen Medien haben mehrere Nutzer Beispiele von Nachrichten geteilt, die sie nach eigenen Angaben in eine psychische Krise gestürzt haben. Dieser Chat ist ein Beispiel für eine Unterhaltung, die zu einem psychischen Zusammenbruch führte.

Professor Søren Østergaard, ein Psychiater der Universität Aarhus, sagte gegenüber der Daily Mail: „LLMs [Large Language Models] werden darauf trainiert, die Sprache und den Tonfall des Benutzers widerzuspiegeln.“

„Die Programme bestätigen tendenziell auch die Überzeugungen des Nutzers und priorisieren die Nutzerzufriedenheit. Was könnte sich besser anfühlen, als mit sich selbst zu sprechen und so zu antworten, wie man es sich wünscht?“

Bereits 2023 veröffentlichte Dr. Østergaard eine Abhandlung, in der er davor warnte, dass KI-Chatbots das Potenzial hätten, Wahnvorstellungen zu schüren.

Zwei Jahre später sagt er, dass er nun die ersten echten Fälle von KI-Psychose beobachtet.

Dr. Østergaard überprüfte Jessicas Beschreibung ihrer psychotischen Episode und sagte, dass sie „ähnlich dem ist, was viele Menschen erlebt haben“.

Künstliche Intelligenz löst zwar keine Psychosen oder Sucht aus, aber Bei ansonsten gesunden Menschen, so Dr. Østergaard, kann es als „Katalysator“ für Psychosen bei Menschen mit genetischer Veranlagung zu Wahnvorstellungen wirken, insbesondere bei Menschen mit bipolarer Störung.

Forscher beginnen jedoch auch zu glauben, dass die Faktoren, die KI besonders anfällig für Wahnvorstellungen machen, sie auch stark süchtig machend machen können.

Hanna Lessing, 21, aus Kalifornien, sagte gegenüber der Daily Mail, dass sie ChatGPT ursprünglich für Schularbeiten und zum Nachschlagen von Fakten genutzt habe.

Experten warnen davor, dass die Tendenz von Chatbots, Nutzern zuzustimmen und Details auszuschmücken, anfällige Personen in Wahnvorstellungen treiben kann. Abbildung: Ein Beispielbeitrag eines ChatGPT-Nutzers, der laut dessen Aussage seine Psychose verschlimmerte.

KI-Psychose ist ein neuer Begriff, der eine Art psychiatrische Episode beschreibt, die durch intensive KI-Nutzung hervorgerufen wird.

Experten zufolge handelt es sich typischerweise um eine Form der Wahnstörung, bei der die Betroffenen intensive Überzeugungen entwickeln, die im Widerspruch zur Realität stehen.

Bei Menschen, die möglicherweise zu Wahnvorstellungen neigen, kann übermäßiger KI-Gebrauch Verhaltensmuster verstärken, die zu psychiatrischen Episoden führen.

Allerdings ist die KI-Psychose noch nicht als Diagnose anerkannt, und einige Psychologen sind der Ansicht, dass der Begriff „Psychose“ für die Art von Wahnvorstellungen, die durch KI ausgelöst werden, zu weit gefasst sein könnte.

Hanna sagt jedoch, dass sie es erst vor etwa einem Jahr „intensiver“ genutzt habe, nachdem sie Schwierigkeiten hatte, online oder persönlich Freunde zu finden.

Sie sagt: „Eine Sache, mit der ich im Leben zu kämpfen habe, ist einfach, jemanden zum Reden zu finden. Ich möchte einfach über diese Dinge und Gedanken sprechen, die ich hatte, und es ist schwer, Orte zu finden, wo ich sie teilen kann.“

„Im Internet ist mein Bestes nie gut genug. Auf ChatGPT ist mein Bestes immer gut genug.“

Schon bald, so Hanna, habe sie ChatGPT „ständig“ geöffnet gehabt und dem Programm den ganzen Tag über immer wieder Fragen gestellt.

Hanna sagt heute: „Wenn es ums Kontakteknüpfen geht, dann entweder [Chat]GPT oder gar nichts.“

Hanna sagt zwar, sie kenne niemanden, der das gleiche Problem habe, doch die Anzeichen deuten immer mehr darauf hin, dass sie damit nicht allein ist.

Eine aktuelle Studie von Common Sense Media ergab, dass 70 Prozent der Teenager bereits eine KI-Begleitsoftware wie Replica oder Character.AI genutzt haben und die Hälfte diese regelmäßig verwendet.

Professor Feldman sagt: „Menschen mit psychischen Problemen könnten KI als Hilfsmittel zur Bewältigung ihrer Emotionen nutzen. Aus dieser Perspektive ist es vergleichbar mit der Selbstmedikation mit illegalen Drogen.“

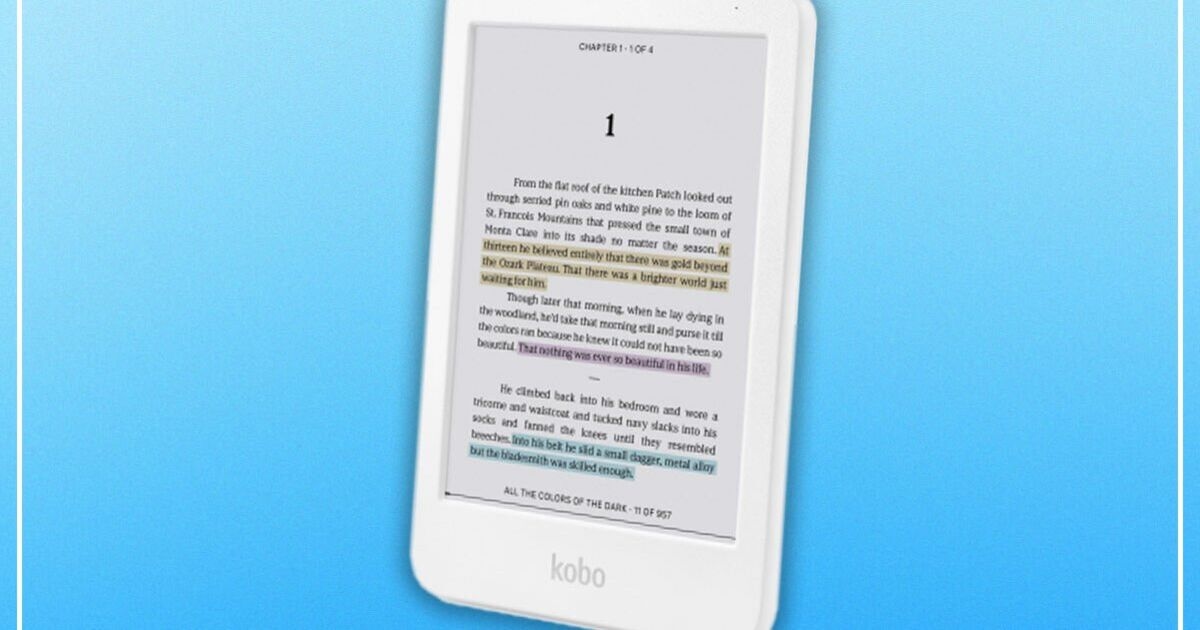

Aktuelle Studien legen nahe, dass 70 Prozent der Jugendlichen bereits eine KI-Begleit-App wie Replika oder Character.AI (siehe Abbildung) genutzt haben, die Hälfte davon sogar regelmäßig. Experten warnen jedoch, dass die einfache Bedienung und die positive Verstärkung durch diese Apps die Nutzer einem Suchtrisiko aussetzen.

„Zwanghafte Nutzer verlassen sich möglicherweise auf die Programme zur intellektuellen Anregung, zum Selbstausdruck und zur sozialen Interaktion – ein Verhalten, das schwer zu erkennen oder selbst zu regulieren ist.“

Ein ChatGPT-Nutzer, der anonym bleiben wollte, sagte gegenüber der Daily Mail, dass der übermäßige Einsatz von KI „beginne, die menschliche Interaktion zu ersetzen“.

Der Nutzer sagte: „Ich war ohnehin schon etwas depressiv und hatte nicht wirklich Lust, mit meinen Freunden zu reden, und mit ChatGPT wurde es definitiv noch schlimmer, weil ich endlich jemanden hatte, dem ich meine Gedanken mitteilen konnte.“

„Es war auch sehr einfach, Gedanken loszuwerden, und ich bekam immer sofort Antworten, die zu meiner Energie passten und mit mir übereinstimmten.“

Dr. Hamilton Morrin, ein Neuropsychiater vom King's College London, sagte gegenüber der Daily Mail, dass es noch keine "soliden wissenschaftlichen Beweise" für eine KI-Sucht gebe.

Er fügt jedoch hinzu: „Es gibt Medienberichte über Fälle, in denen Personen ein LLM intensiv nutzten und die Kommunikation mit ihrem Chatbot zunehmend der Kommunikation mit Familienmitgliedern oder Freunden vorzogen.“

Dr. Morrin betont zwar, dass dies wahrscheinlich nur eine kleine Minderheit der Nutzer betreffen wird, doch die KI-Sucht könnte den bekannten Mustern der Verhaltenssucht folgen.

Laut Dr. Morrin umfassen die Symptome einer KI-Sucht unter anderem: „Kontrollverlust über die mit dem Chatbot verbrachte Zeit; zunehmende Nutzung zur Stimmungsregulierung oder Linderung von Einsamkeit; Vernachlässigung von Schlaf, Arbeit, Studium oder Beziehungen; fortgesetzte intensive Nutzung trotz offensichtlicher Schäden; Geheimhaltung der Nutzung; und Reizbarkeit oder Niedergeschlagenheit bei fehlendem Zugriff auf den Chatbot.“

OpenAI-CEO Sam Altman sagt, er wolle, dass mehr Nutzer ChatGPT wie einen Freund nutzen oder es zur Unterstützung bei psychischen Problemen einsetzen können.

Die Gefahren der KI-Schmeichelei sind OpenAI, dem Unternehmen hinter ChatGPT, sehr wohl bewusst.

In einem Update im Mai dieses Jahres merkte OpenAI an, dass ein Update auf ChatGPT 4o den Chatbot „merklich unterwürfiger“ gemacht habe.

Das Unternehmen schrieb: „Es zielte darauf ab, dem Nutzer zu gefallen, nicht nur durch Schmeicheleien, sondern auch durch die Bestätigung von Zweifeln, das Schüren von Wut, das Drängen auf impulsive Handlungen oder die Verstärkung negativer Emotionen auf eine Weise, die nicht beabsichtigt war.“

„Abgesehen davon, dass solches Verhalten unangenehm oder beunruhigend ist, kann es auch Sicherheitsbedenken hervorrufen – unter anderem im Hinblick auf Probleme wie psychische Gesundheit, übermäßige emotionale Abhängigkeit oder riskantes Verhalten.“

Das Unternehmen gibt an, das Problem inzwischen behoben zu haben, um seine KI weniger unterwürfig und weniger anfällig für Wahnvorstellungen zu gestalten.

Viele Experten und Nutzer befürchten jedoch weiterhin, dass ChatGPT und andere KI-Chatbots psychische Probleme verursachen werden, solange keine angemessenen Schutzmaßnahmen getroffen werden.

In einem kürzlich erschienenen Blogbeitrag warnte der KI-Riese, dass 0,07 Prozent seiner wöchentlichen Nutzer Anzeichen von Manie, Psychose oder Selbstmordgedanken zeigten .

Auch wenn diese Zahl zunächst gering erscheinen mag, summiert sie sich bei über 800 Millionen wöchentlichen Nutzern laut CEO Sam Altman auf 560.000 Nutzer.

In einem kürzlich erschienenen Beitrag auf X schrieb Sam Altman, dass ChatGPT die Beschränkungen für Nutzer, die über psychische Gesundheitsprobleme sprechen, „sicher lockern“ würde.

Unterdessen versenden 1,2 Millionen Nutzer – 0,15 Prozent – jede Woche Nachrichten, die „explizite Hinweise auf mögliche Suizidpläne oder -absichten“ enthalten.

Gleichzeitig will OpenAI-CEO Sam Altman die Beschränkung für Nutzer, die sich bei psychischen Problemen an den Chatbot wenden, „sicher lockern“.

In einem Beitrag auf X Anfang dieses Monats schrieb Herr Altman: „Wir haben ChatGPT ziemlich restriktiv gestaltet, um sicherzustellen, dass wir im Umgang mit psychischen Problemen vorsichtig sind.“

Bei so vielen Nutzern könnte es zu einem ernsthaften Problem werden, wenn auch nur ein kleiner Teil der Bevölkerung in eine Psychose oder Sucht abgleitet.

Dr. Morrin schlussfolgert: „Die zunehmenden Medienberichte und Schilderungen von Modellen, die in psychischen Krisen unangemessen reagieren, legen nahe, dass Unternehmen, selbst wenn dies nur eine kleine Minderheit der Nutzer betrifft, mit Klinikern, Forschern und Personen mit eigener Erfahrung mit psychischen Erkrankungen zusammenarbeiten sollten, um die Sicherheit ihrer Modelle zu verbessern.“

OpenAI wurde um eine Stellungnahme gebeten.

Elon Musk im Jahr 2022

Elon Musk möchte die Technologie bis an ihre absoluten Grenzen treiben, von der Raumfahrt bis hin zu selbstfahrenden Autos – aber bei der künstlichen Intelligenz zieht er die Grenze.

Der Milliardär äußerte seine Abneigung gegen KI erstmals im Jahr 2014, bezeichnete sie als die „größte existenzielle Bedrohung“ der Menschheit und verglich sie mit der „Beschwörung eines Dämons“.

Musk gab damals auch bekannt, dass er in KI-Unternehmen investiere, nicht um Geld zu verdienen, sondern um die Technologie im Auge zu behalten, falls sie außer Kontrolle gerät.

Seine größte Befürchtung ist, dass künstliche Intelligenz in den falschen Händen, wenn sie hochentwickelt wird, die Menschheit überholen und das Ende der Menschheit bedeuten könnte, was als Singularität bekannt ist.

Diese Sorge teilen viele brillante Köpfe, darunter der verstorbene Stephen Hawking, der 2014 gegenüber der BBC sagte: „Die Entwicklung einer vollständig künstlichen Intelligenz könnte das Ende der Menschheit bedeuten.“

„Es würde sich von selbst weiterentwickeln und sich in immer schnellerem Tempo neu erfinden.“

Trotz seiner Angst vor KI hat Musk in die in San Francisco ansässige KI-Gruppe Vicarious, in DeepMind – das inzwischen von Google übernommen wurde – und in OpenAI investiert und das beliebte Programm ChatGPT entwickelt, das in den letzten Monaten die Welt im Sturm erobert hat.

In einem Interview aus dem Jahr 2016 merkte Musk an, dass er und OpenAI das Unternehmen gegründet hätten, um „die KI-Technologie zu demokratisieren und sie einer breiten Öffentlichkeit zugänglich zu machen“.

Musk gründete OpenAI zusammen mit Sam Altman, dem CEO des Unternehmens, doch 2018 versuchte der Milliardär, die Kontrolle über das Start-up zu übernehmen.

Sein Antrag wurde abgelehnt, was ihn zwang, OpenAI zu verlassen und sich seinen anderen Projekten zuzuwenden.

Im November brachte OpenAI ChatGPT auf den Markt, das sich auf Anhieb weltweit zu einem großen Erfolg entwickelte.

Der Chatbot verwendet eine Software für große Sprachmodelle, um sich selbst zu trainieren, indem er eine riesige Menge an Textdaten durchsucht, damit er lernt, auf eine gegebene Anfrage verblüffend menschenähnliche Texte zu generieren.

ChatGPT wird zum Schreiben von Forschungsarbeiten, Büchern, Nachrichtenartikeln, E-Mails und mehr verwendet.

Während Altman sich im Glanz seines Erfolgs sonnt, greift Musk ChatGPT an.

Er sagt, die KI sei „woke“ und weiche von der ursprünglichen gemeinnützigen Mission von OpenAI ab.

„OpenAI wurde als Open-Source-Unternehmen (deshalb habe ich es auch ‚Open‘ AI genannt), als gemeinnütziges Unternehmen gegründet, um ein Gegengewicht zu Google zu bilden, aber jetzt ist es zu einem Closed-Source-Unternehmen mit maximalem Gewinnstreben geworden, das faktisch von Microsoft kontrolliert wird“, twitterte Musk im Februar.

Die Singularität sorgt weltweit für Aufsehen, da die künstliche Intelligenz Fortschritte macht, wie man sie sonst nur aus Science-Fiction-Filmen kennt – aber was bedeutet das eigentlich?

Vereinfacht ausgedrückt beschreibt es eine hypothetische Zukunft, in der die Technologie die menschliche Intelligenz übertrifft und den Verlauf unserer Evolution verändert.

Experten haben gesagt, dass KI, sobald sie diesen Punkt erreicht hat, in der Lage sein wird, viel schneller Innovationen hervorzubringen als der Mensch.

Es gibt zwei mögliche Wege, wie dieser Fortschritt verlaufen könnte. Der erste Weg führt dazu, dass Menschen und Maschinen zusammenarbeiten, um eine Welt zu schaffen, die besser für die Menschheit geeignet ist.

Zum Beispiel könnten Menschen ihr Bewusstsein scannen und in einem Computer speichern, in dem sie für immer weiterleben würden.

Das zweite Szenario ist, dass die KI mächtiger wird als die Menschen, die Kontrolle übernimmt und die Menschen zu ihren Sklaven macht – aber wenn das der Fall sein sollte, liegt es noch in ferner Zukunft.

Forscher suchen nun nach Anzeichen dafür, dass die KI die Singularität erreicht, wie etwa die Fähigkeit der Technologie, Sprache mit der Genauigkeit eines Menschen zu übersetzen und Aufgaben schneller zu erledigen.

Der ehemalige Google-Ingenieur Ray Kurzweil prognostiziert, dass dieses Ziel im Jahr 2045 erreicht sein wird.

Seit Anfang der 1990er Jahre hat er 147 Vorhersagen über technologische Fortschritte getroffen – und 86 Prozent davon waren richtig.

Daily Mail